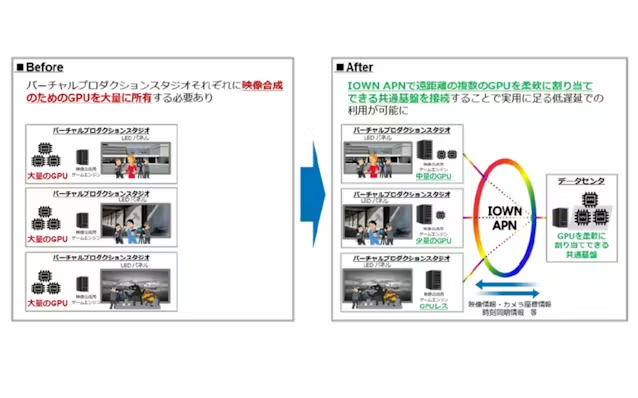

TBSテレビと同社の番組制作を担うTBSアクト、NTTの3社は、現実の被写体と仮想空間をリアルタイムで合成する「バーチャルプロダクション」の長距離リモート実証実験を実施したと発表した。約3000キロメートル離れた拠点間をNTTの次世代通信基盤「IOWN(アイオン)」の技術で接続し、遠隔の画像処理半導体(GPU)サーバーで生成したCG(コンピューターグラフィックス)背景を配信してリアルタイム合成できることを確認した。

実験では、日本縦断相当の約3000キロメートル離れた拠点間をIOWN技術で接続。片方拠点のGPUサーバーで稼働する映像合成用ゲームエンジン「アンリアルエンジン」を用いてCG背景を生成し、もう片方の拠点へ配信する技術検証を行った。

バーチャルプロダクションでは、GPUサーバーで生成したCG背景を巨大な発光ダイオード(LED)の画面(LEDウオール)に表示し、手間の被写体映像と同時に撮影する。実証の結果、アンリアルエンジンの時刻同期や撮影カメラの座標情報、照明の制御信号など、連携に必要な様々なデータをリアルタイムに伝送できることを確認した。

また、カメラとLEDウオールに表示したCG背景の間で5フレーム(約84ミリ秒)の低遅延を確認し、従来のようなスタジオにあるGPUサーバーを使うのと変わらない品質で映像制作業務ができることも実証した。

今回の取り組みは、NTTが19日から東京都内で開催している研究開発の展示会「NTT R&Dフォーラム 2025」に出展している。

本記事は編集プロセスの一部で生成AIの技術を活用しています。生成結果はそのまま利用せず、編集者・記者が確認・加筆・修正したうえで掲載しています。鄭重声明:本文の著作権は原作者に帰属します。記事の転載は情報の伝達のみを目的としており、投資の助言を構成するものではありません。もし侵害行為があれば、すぐにご連絡ください。修正または削除いたします。ありがとうございます。